כולנו רוצים שגוגל יבקר יותר באתר שלנו ויאנדקס כל תוכן חדש שמתפרסם באופן מיידי (אם זה היה תלוי בנו, לא היינו רוצים שיצא בכלל מהאתר). הרי בסופו של דבר אנחנו רוצים טראפיק וככל שהתוכן יתאנדקס מהר יותר, כך הוא גם יופיע בתוצאות החיפוש מהר יותר.

אז איך גורמים לו לבקר יותר? איך לגביר את תדירות האינדוקס? המדריך הבא מדגים מספר טכניקות שימושיות שיסייעו לכם “לכלוא” (במובן החיובי כמובן) את הזחלן של גוגל באתר שלכם.

1. הקטינו את זמן הטעינה ובצעו אופטימיזציה – Googlebot crawls with a budget

לא רבים יודעים, אך עקרון הזחילה מבוסס בסופו של דבר על תקציב. דמיינו שבכל רגע נתון זוחלים אינסוף גוגלבוטים באתרים שונים ברחבי העולם בנסיון לאנדקס מידע חדש. האופרציה הזו מאד יקרה לפתעול (שרתים, חשמל וכו’…). לכן ככל שהסריקה “קשה” יותר, כך מנוצל יותר תקציב לשם כך ולכן זה יקטין את התדירות. להלן מספר שגיאות סריקה נפוצות שמגדילות את התקציב:

- טפלו בעמודי שגיאה 404 – בעבר פרסמתי מדריך ליצירת עמודי שגיאה 404 ובו הסברתי בהרחבה את חשיבות העמוד עבור משתמשים ומנועי החיפוש. טיפול בקודי סטטוס HTTP מפחיתים את ההתעסקות של הגוגלבוט בתהליך הסריקה, לכן אני ממליץ בחום להגדיר באתר עמודי שגיאה 404.

- הקטינו את זמן טעינת העמודים – חשוב לבצע אופטימיזציה של קוד האתר בכדי להקל על הגוגלבוט בתהליך הזחילה. כמו כן, אני ממליץ לטפל בגודל הקבצים (כגון תמונות, פידיאפים וכו’). מדריך מקיף שפורסם אצלי בעבר מסכם את הנושא של שיפור זמן טעינת עמודים.

- צרו היררכייה וניווט ברור – כאשר הזחלן נוחת בדף מסוים הוא מגיע לדפים אחרים באתר באמצעות קישורים. אם יתקשה לעבור בין הדפים באתר או שיידרשו לו יותר מדי מעברים בכדי להגיע לעמודים מסוימים, זה יקשה על הסריקה ויגדיל את התקציב (ראה סעיף 1). לכן השקיעו במבנה הקישורים הפנימיים בין הדפים, צרו “פירורי לחם” (Bread Crumbs) וצרו את תפריטי הניווט בצורה אופטימלית. המדריך הבא יסייע לכם באופטימיזציה להיררכייה ומבנה האתר.

2. המנעו מתוכן משוכפל

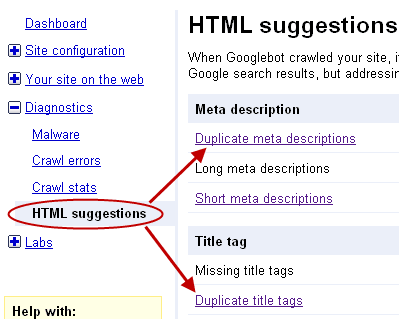

כאשר הגוגלבוט נתקל בתוכן חדש והוא מאבחן כי לא מדובר בתוכן ייחודי אלא בשכפול, זה מצריך ממנו התייחסות שגוררת עיכוב בסריקה. כמובן לא מדובר בעיכוב משמעותי אבל כשהרשת גדולה כל כך, כל עיכוב ולו הכי קטן משפיע. לכן בכדי להימנע משכפול תוכן, השתדלו ליצור אך ורק תוכן ייחודי. הכוונה לא רק בטקסט עצמו אלא גם בתגיות המטא (טייטל, דסקריפשן). באפשרותכם לראות ב- Webmaster Tools את כל השכפולים באתר (כנסו ל- HTML Suggestions):

3. צרו מפת אתר XML והוסיפו אותה לגוגל

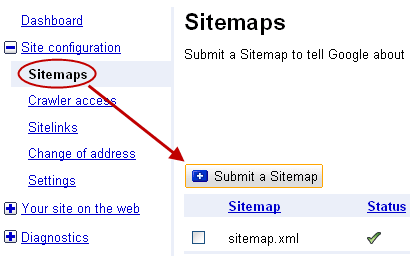

הרבה אנשי SEO טוענים שמדובר בשמועה ומפת אתר XML כבר לא משפיעה על תדירות הסריקה כפי שהשפיעה בעבר. אז מהנסיון האישי שלי הרשו לי להגיד שזה לא מדוייק, ובכל המקרים זה דווקא כן שיפר אצלי את זחילת ואינדוקס התוכן החדש פי כמה וכמה רמות. אם חושבים על זה, קל מאד להבין את ההגיון לכלל הזה – המפה, מעצם ייעודה, מעדכנת את גוגל בכל שינוי חדש שקורה באתר ולכן למעשה מזמינה כל פעם את הזחלן מחדש.

מהי מפת אתר XML ואיך יוצרים אותה?

XML הוא תקן ופורמט לצורך הצגת נתונים באינטרנט כך שמערכות שונות יוכלו לקרוא אותו. מפת אתר XML היא למעשה קובץ שמיועד למנועי חיפוש, והוא מכיל רשימות URL של האתר. זוהי מפה דינמית במבנה שלה, והיא משקפת את השינויים שמתרחשים באתר בזמן אמת.

אלו השדות שבד”כ כל מפה כזו מכילה:

- URL – כתובת הדף (מפה אחת יכולה להכיל עד 50,000 כתובות שונות)

- Priority – העדיפות שיש לדף. ככל שהדף חשוב יותר מבחינה היררכית, כך מומלץ שהעדיפות שלו תהיה גבוהה יותר. רוב הכלים משתמשים בסקלה של 0.1 עד 1, ואחרים מאפשרים לבחור באחוזים.

- Change Frequency – הערכה גסה שלכם מהי תדירות השינוי של אותו דף (כמובן זה לא חייב להיות מדוייק). הפעם הסקלה נקבעת לפי תקופות: daily, weekly, monthly.

- LastChange – מציין את התאריך והשעה המדוייקת שבה נעשה השינוי בדף.

יש מספר דרכים ליצור מפת אתר כזו:

- פלאגין – אם אתם משתמשים בוורדפרס החיים יפים, פשוט השתמשו בתוסף הזה

- שירותים וכלים – יש כל מני כלים באינטרנט שמאפשרים ליצור מפת אתר. רוב השירותים החינמיים מאפשרים ליצור מפה מוגבלת מבחינת כמות העמודים, ואם רוצים שלא תהיה הגבלה יש צורך לשלם. השירותים הפופולאריים שאני מכיר הם A1 Sitemap Generator ו- XML-Sitemaps.

- שיטת עשה זאת בעצמך – אנשי קוד יוכלו להתמודד בלי בעיה עם בנייה ידנית של מפה כזו. את כל ההסברים המפורטים ניתן למצוא בדף העזרה של גוגל.

לאחר שיצרנו מפת אתר XML יש להוסיף אותה ל- Google Webmaster Tools:

4. קשרו לתוכן שלכם משירותי מדיה חברתית

דרך מצויינת לגרום לגוגל לסרוק מהר כל תוכן חדש שאתם מפרסמים היא להשתמש בשירותי מדיה חברתית כגון טוויטר ו- FriendFeed שעליהם אני הכי ממליץ עליהם בהקשר הזה. בפלטפורומות הללו נוצר תוכן בתדירות גבוהה מאד ולכן גוגל מבקר בו לעיתים תכופות. כמו כן, מפנים אליהם הרבה מאד קישורים איכותיים ולכן הפייג’ראנק שלהם הוא 8/9 – מה שעוד יותר מגדיל את הסריקה (ראה סעיף קודם). כך ניתן להשתמש בהם:

- FriendFeed – זהו שירות פידים כללי שמרכז עדכונים מכל הפעילות שלכם ברשת. לאחר יצירת הפרופיל, מוסיפים אליו פידים של RSS וקישורים לפרופילים שלכם ברשתות חברתיות בהן אתם פעילים. כעת בכל פעם שתוסיפו תוכן באחד מהמקורות שהגדרתם, הוא יופיע בדף הפרופיל שלכם עם כתובת משלו. רק כדי להבין את הכוח של הכלי הזה – כאשר אני מפרסם פוסט בבלוג שלי, הוא מתאנדקס בד”כ קודם ב- FriendFeed ורק לאחר מכן בבלוג.

- טוויטר – כולנו יודעים איך הכלי הזה הפך לאחד מכלי התקשורת הפופולאריים בעולם בזמן האחרון. לא סתם גוגל החליטו לשלב עדכונים מטוויטר בתוצאות החיפוש. אין צורך לשלוח טוויט ידנית, פשוט הרשמו לשירות TwitterFeed והוסיפו אליו את ה-RSS שלכם. ככה בכל פעם שתפרסמו משהו חדש אוטומטית יישלח ציוץ. בכדי להבין את הפוטנציאל של טוויטר בשיפור האינדוקס, אני מציע לקרוא את הפוסט שפורסם השבוע ב- SEOmoz בהקשר הזה: Using Twitter For Increased Indexation.

יש כמובן עוד הרבה שירותים מהסוג הזה אבל אלו המומלצים ביותר מבחינתי (הכוונה רק לצרכי אינדוקס).

5. בצעו אופטימיזציה ל- Pagerank של עמוד הבית

ה- Pagerank הוא מדד שמשקף את כמות ואיכות הקישורים שמצביעים על דף מסוים באינטרנט. ככל שיותר דפים עם פייג’ראנק גבוה יצביעו על הדף, כך גם הציון שלו יגדל. ההנחה כי פייג’ראנק גבוה מגדיל את תדירות הסריקה נובעת מכך שככל שהציון יהיה גבוה יותר, כך יש יותר סיכוי כי מדובר במקור סמכותי שיש לו תוכן כלשהו מהסוגים הבאים:

- מעניין ומקורי בצורה יוצאת דופן

- מתחדש על בסיס קבוע

- נחשב לאתר סמכותי ואמין בתחומו

אחרת מדוע כל כך הרבה מקשרים אליו? ואם אכן כך הדבר, כדאי מאד לגוגל לבקר הרבה באתר שכזה בכדי לראות מה התחדש.

כמובן זהו רק המצב האידיאלי, במציאות המצב שונה לחלוטין. עם גודל ומסחריות האינטרנט של ימינו, אתרים יכולים לרכוש קישורים מאתרים עם פייג’ראנק גבוה וכך להגדיל את הפייג’ראנק שלהם באופן שאינו טבעי. מהסיבה הזו לדעתי לפרמטר הזה יש משקל קטן יחסית בכל הנוגע לתדירות סריקה.

למרות שאני מפקפק בפרמטר הזה, אני עדיין ממליץ לדאוג להגדיל את ה- Pagerank של העמודים החשובים באתר ובעיקר של עמוד השער של האתר – עמוד הבית. יש 2 סיבות עיקריות מדוע מומלץ להשקיע את מירב המאמצים דווקא בעמוד הבית:

- מכיוון שזהו העמוד הראשי באתר, בד”כ נוהגים לקשר ממנו לכל העמודים החשובים ולהציג בו עדכונים מכל אגפי התוכן באתר. לדוגמא אם יש לכם אגף חדשות, בדף הבית יופיעו “חדשות אחרונות”. לכן מספיק שהגוגלבוט יגיע לדף הבית בכדי שיבחין בכל השינויים שנעשו וכך גם יסרוק אותם.

- עמוד הבית מקשר לכל העמודים החשובים, לכן אם נחזק אותו עם קישורים ונגדיל את ה- Pagerank שלו, למעשה אנו נגדיל בעקיפין את ה-Pagerank של העמודים החשובים באתר.

6. עדכנו תוכן בתדירות גבוהה בעמודים הדומיננטיים

גוגל אוהב תוכן איכותי שמתחדש ואם אפשר – הרבה. כשמו של “גוגל” (הספרה 1 ואחריה 100 אפסים), מטרתו לאנדקס כמה שיותר מידע ברשת במטרה להפוך לאינדקס התוכן הגדול ביותר באינטרנט. לכן אם גוגל מבחין כי אתר מסוים מוסיף הרבה תוכן בתדירות גבוהה, הוא ידאג לבקר בו לעיתים תכופות יותר במטרה לאנדקס את התוכן ולהגדיל את האינדקס שלו.

כפי שכתבתי בסעיף הקודם על הפייג’ראנק, אני ממליץ להוסיף בעמוד הבית ובעמודים החשובים באתר קישורים לתכנים חדשים שמתפרסמים, מכיוון שאלו העמודים הנסרקים ביותר. לדוגמא: אם יש לכם מאמרים באתר הוסיפו סקשן “מאמרים אחרונים” איפשהו בתפריט וקשרו מתוכו למאמרים האחרונים שפרסמתם. אם תשימו לב, עמוד הבית שלי למשל בנוי כמו סוג של אגריגטור שמציג את התוכן האחרון שפורסם בכל האגפים השונים באתר – שאלות ותשובות, בלוג ופינת החדשות. מבחינת גוגל, מספיק שיקפוץ לעמוד הבית בכדי לדעת מה התוכן החדש שהתווסף אותו יש לאנדקס.

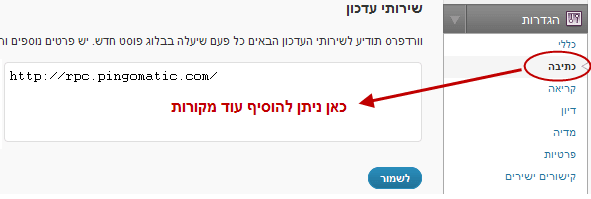

7. הרשמו לשירותי פינג

Ping הינו אוסף של נתונים שנשלח ברשת ממקור כלשהו ליעד כלשהו בכדי לוודא שיש תקשורת. המקור יכול להיות האתר שלכם למשל והיעד – מנועי חיפוש, שירותי מדיה חברתית וכו’. כלומר במילים אחרות: אם יש לכם בלוג בוורדפרס למשל והגדרתם שירות פינג, וורדפרס תודיע לשירותים שונים בכל פעם שיעלה בבלוג פוסט חדש.

אז איך מוסיפים שירותי פינג?

לאחר ההתקנה של וורדפרס, ברירת המחדל כוללת שירות פינגים אחד שכבר מוטמע במערכת שלכם (Pingomatic), אך ביכולתכם להוסיף עוד מספר שירותי פינג XML-RPC באופן הבא:

אם אתם לא משתמשים בוורדפרס כפלטפורמה לבלוגים, פשוט הוסיפו את הבלוג שלכם ידנית לשירות של Pingomatic.

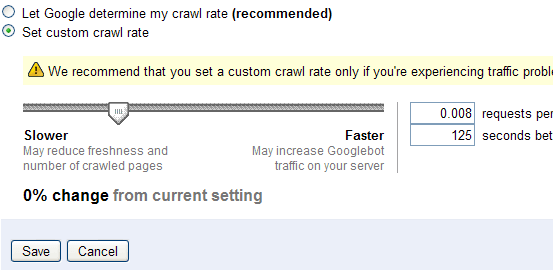

8. הגדירו את התדירות דרך Google Webmaster Tools

אם עשיתם את כל מה שאפשר ועדיין תדירות הסריקה לא מוצאת חן בעיניכם, ביכולתכם להגדיר אותה ידנית דרך ממשק הניהול של – Google Webmaster Tools. אני כמובן פחות ממליץ על האפשרות הזו (כמו שאני לא ממליץ להוסיף לגוגל אתרים חדשים בכדי ליידע על קיומם), אך אם האפשרות הזו קיימת כנראה שיש לה משמעות. היא נמצאת ב- Site Configuration–>Settings:

גוגל כמובן ממליצים במפורש להגדיר את התדירות באופן ידני אך ורק אם ישנן בעיות טראפיק בשרת. הסיבה שגוגל מעדיף את הדרך הטבעית היא בגלל שאם כל אחד יקבע מהי תדירות הסריקה, כולם פשוט ישר יגדירו את הגודל המקסימאלי. ואם כולם יגדירו את הגודל המקסימלי – איך גוגל ידע לעשות תעדוף?

איך מנטרים ועוקבים אחרי הסריקות באתר?

קודם כל לפני שאנחנו מתחילים לדאוג ולהילחץ איך מגדילים את הסריקה והאינדוקס באתר, יש צורך בכלל לאבחן האם יש לנו בעיה. בכל מקרה, כדאי תמיד להיות עם היד על הדופק ולעקוב אחרי תדירות הזחילה באתר בכדי שניתן יהיה להגיב מהר במקרה של ירידות חדות. להלן מספר דרכים לעשות זאת:

- גוגל וובמסטר טולס – אם תלכו ל- Diagnostics–>Crawl Stats, תוכלו לראות 3 גרפים שמשקפים את פעילות הגוגלבוט ב-90 הימים האחרונים. הגרף הראשון מציג את מספר הדפים שנסרקו ביום, בשני את מספר הקילובייטים שירדו ביום ובשלישי את הזמן שלקח להוריד דף. מדובר בנתונים מאד כלליים וקשה מאד לקבל מהם אינדיקציה כלשהי לגבי איכות האתר ומהם הדפים הבעייתיים\מעולים.

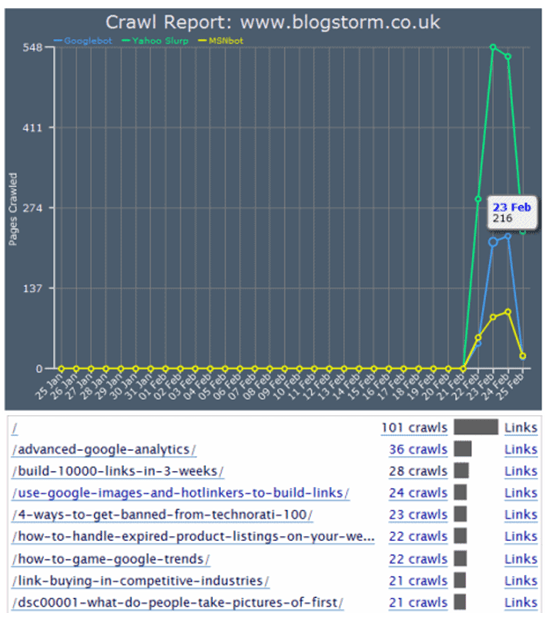

- פלאגין לוורדפרס – למרות שוובמסטר טולס מספקים מספר גראפים מעניינים, עדיין לא ניתן לחלץ מהם מידע מאד חיוני כגון התפלגות של כמות הסריקות בין כל עמודי האתר. זה בדיוק מה שהפלאגין crawl rate tracker פותר. מלבד הגוגלבוט, הפלאגין מאפשר גם לראות על ציר הזמן את תדירות הסריקות של יאהו ו-MSN (שימו לב את מספר הסריקות שניתן לראות בהתאם לכל דף באתר):

מה אתם עושים כדי לגרום לגוגל לבוא לבקר באתר שלכם?

הטיפים שהצגתי כאן מבוססים על הנסיון האישי שלי וכולם נבדקו. אני אישית משתמש בבלוג שלי בכל השיטות הללו (חוץ מ- #8) והתוצאות לא רעות בכלל – כל פוסט אצלי מתאנדקס בפחות מ-10 שניות.

באילו שיטות אתם משתמשים? מה לדעתכם הכי אפקטיבי מכל מה שהוצג כאן? האם אתם מכירים שיטות נוספות? אשמח מאד אם תשתפו מהידע והנסיון שלכם.