כבר למעלה משנה לא יצא לי לכתוב כאן ואני מצטער על כך מראש. זו הייתה שנה רוויה באתגרים. בשנה האחרונה אני מתגורר במיאמי השמשית לשם עברתי עם התפתחות המיזם החדש שלי אשר עליו אני עובד כבר כשנה וחצי. במקביל, כיוון שהרוב המכריע של הלקוחות שלי נמצא בארה”ב וקנדה, זה רק המחיש את חשיבות המעבר.

הפוסט הזה נכתב בעקבות שינויים רבים המתחוללים בגוגל. מדובר בשינויים הקשורים לחווית משתמש, תכנים ולוקליזציה, אשר מובילים אותנו, משווקי האתרים, להתרכז בעיקר בהיבטים כמו מהירות האתר ותכנים. אך האם אנו שמים את הדגש במקומות הנכונים? להערכתי, ישנם היבטים שלמים בקידום האתר אשר אינם זוכים לתשומת הלב הנדרשת, כאשר הם טומנים בחובם אוצר מבחינת משמעות וכוח קידום. אחד מן הנושאים שנוטים להתעלם מהם הוא איכות הזחילות (crawlability) של האתר.

אכן, יש שיטענו שזה לא בדיוק נופל תחת SEO, אלא יותר מהווה חלק מ-GBO (או Googlebot Optimization). עם זאת, בעיניי כל פעולה שמטרתה לשפר את הדירוג האורגני ואת כמות הכניסות האורגנית של האתר, קשורה ל-SEO. אם גם אתם מרגישים כך, תשאלו את עצמכם: האם אתם בודקים נכון את מידת הזחילות של האתר, ואף מביאים את האתר לנקודה בה הוא צריך להיות?

רבים כבר הספידו את ה-SEO. זה רווח לפני חמש שנים, לפני שנתיים ואפילו לפני כמה שבועות, כאשר אתר גדול ונחשב –ahrefs.com – הספיד את כל תחום ה-on-page SEO לאחר בחינת 2 מיליון ביטויים. מיותר לציין שאיני מסכים עם הקביעה, בין היתר מכיוון שבחינת 2 מיליון ביטויי חיפוש היא בבחינת “טיפה בים” כאשר גוגל מדווחים על למעלה מ-2 טריליון (!) חיפושים בשנה. בהנחה שרק 25% מסך כל החיפושים הינם ייחודיים, מדובר על בחינה של 0.0004% בלבד.

מניסיוני, מאידך, ניתן להבחין בשיפור משמעותי בדירוג עם כל לקוח חדש אשר מגיע אלינו, לאחר ביצוע יישור קו מקיף בכל מה שקשור ל-on-page SEO. לפני כשנה כתבתי פוסט ארוך ומפורט, אשר עדיין רלוונטי, באתר Search Engine Journal, אשר מסביר, צעד אחרי צעד, כיצד לבצע ניתוח כזה בצורה מעמיקה שאינה מסתכמת רק בתיקון כותרות, הוספת אי אלו מילות חיפוש בתוכן, שיפור מהירות בסיסי והוספת תגי-אלט לתמונות.

מהי זחילה ומדוע היא חשובה כל כך?

מנועי חיפוש זוחלים באופן קבוע באינטרנט באמצעות זחלנים (crawlers). המטרה שלהם היא לגלות דפים חדשים ברחבי האינטרנט, על מנת להוסיף אותם לאינדקס. שיטת הזחילה השתנתה לאורך השנים מספר פעמים, והתייעלה עם ההתרבות האדירה בדפי האינטרנט. לכן, כיום גוגל ומנועי חיפוש אחרים עושים מאמץ לאנדקס דפים שנראים חשובים בעיקר לפי ה-pagerank שלהם. לא מדובר על הציון שהיינו רואים בסרגל הכלים של גוגל, אלא על הציון שגוגל עצמם נותנים לדף. ציון זה היה אמור להשתקף בסרגל הכלים, אך כמעט אף פעם לא היה מעודכן, עד שגוגל החליטו להסירו לחלוטין. בכל אופן, הציון עדיין קיים מבחינת גוגל, פשוט לא נגיש לנו יותר.

רבים טועים לחשוב שגוגל מגיע לזחול באתר שלהם מדי שבוע, שבועיים או חודש, ולכן חשוב לבצע שינויים בפרקי זמן אלו בכדי שכשיגיע, נהיה מוכנים לזחילה. למעשה, גוגל מגיע לזחול באתר מדי כמה שניות/דקות. עם זאת, הוא לא מאנדקס בקצב הזה בדיוק מסיבת דירוג החשיבות שהזכרתי קודם. קצב האינדוקס שלכם יעלה אם גוגל יזהה שהאתר מתעדכן בקצב מהיר, עם תוכן איכותי ורלוונטי. לדוגמה, אם הבוט מגיע לאתר מסויים, משווה גירסה קיימת לגרסה השמורה אצלו ומזהה שאין שינוי, פעם אחרי פעם, גוגל יחל להגדיל את מרווחי הזחילה והאינדוקס בהתאם. לעומת זאת, במקרה של אתרי חדשות, לדוגמה, גוגל עשוי לעיתים לאנדקס דפים בכל כמה שניות, משום שבכל פעם שהבוט מגיע לזחול בדפים, הוא מזהה תוכן חדש. זאת, בצירוף מדד הפופולריות של האתר, מסמנים לגוגל שיש לאנדקס ולסרוק את האתר בתכיפות מאוד גבוהה.

בכל פעם שגוגל מגיע אל האתר שלכם, הבוט מתחיל לזחול, משווה גרסאות של דפים ומוריד דפים חדשים שמצא. כל דף שהוא מוריד, משתמש בכמות מסויימת של רוחב פס. כאשר רוחב הפס המוקצה לאתר נגמר, הבוט מפסיק לזחול וממשיך הלאה. השם המקצועי של התהליך הזה הוא Crawl Budget. ככל שהאתר שלכם יהיה נגיש יותר, מהיר יותר ובעל תוכן איכותי יותר, ‘תקציב’ רוחב הפס שהוקצה לכם ינוצל טוב יותר. מלבד העובדה שמהירות האתר מהווה פקטור בדירוג, ברור לכל שכשהאתר יהיה מהיר יותר, יותר דפים יהיו נגישים לגוגל בכל זחילה, וכך יותר דפים יאונדקסו, מה שיגביר את הסיכוי לכך שיותר דפים מהאתר שלכם יופיעו בדירוג תוצאות חיפוש עבור מגוון ביטויים. לבסוף, כל זה מתורגם לעלייה בתנועה האורגנית לאתר.

אילו כלים צריך?

על מנת להתחיל את הבדיקות, נעשה שימוש בכלים שונים, שנמצאים בשימוש שוטף ממילא:

- Google Analytics

- Google Search Console

- Bing Webmaster Tools

- Screaming Frog

- Web Developer Toolbar

שלב 1

נתחיל בצעד בסיסי שעשוי להראות טריוויאלי לרבים, אך הוא חשוב מאוד: בדיקת קובץ ה-robots.txt שלנו כדי לוודא שאנחנו לא חוסמים חלקים חשובים מהאתר בטעות/בכוונה. קודם לכן, מן הסתם, ודאו שיש לכם בכלל קובץ robots.txt ואם הוא הועלה ל-Google Search Console. על מנת לבדוק האם יש לנו קובץ פעיל נקליד robots.txt ישירות לאחר שם הדומיין:

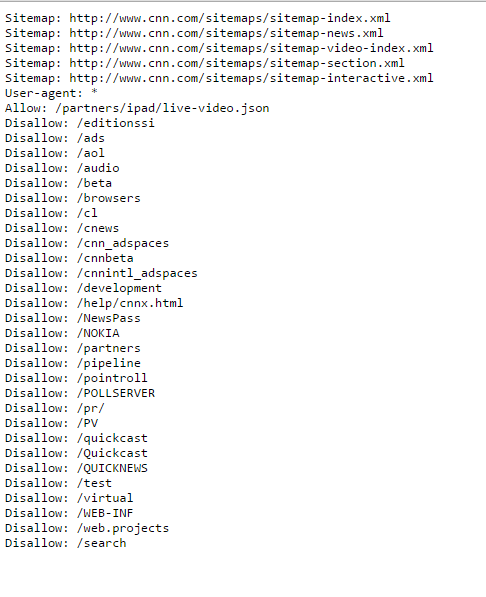

אם ישנו קובץ מעודכן, תראו מסך לבן שמכיל בדרך כלל כמה שורות ונראה כך:

דרך נוספת לוודא שיש לכם קובץ robots.txt היא לגשת ל-Google Search Console ולראות אם הזנתם שם את המיקום של הקובץ, ואז לבדוק אם גוגל מזהה אותו.

Crawl>robots.txt Tester

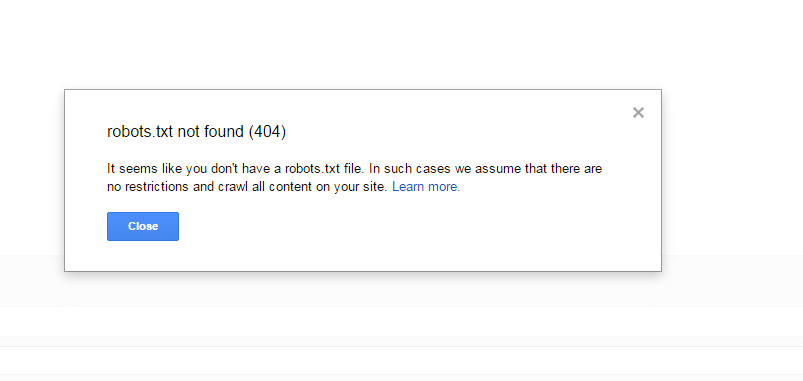

אם גוגל לא מזהה קובץ כזה, תראו הודעה כזו:

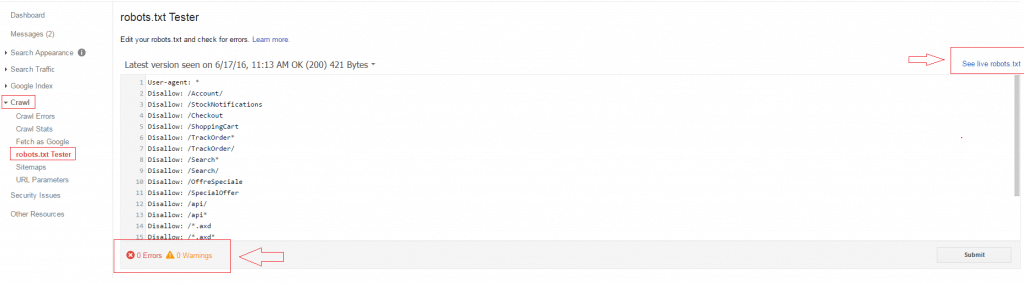

לחילופין, אם יש קובץ ומיקומו מעודכן, תוכלו לבחון אם גוגל מזהה בו שגיאות ואף כיצד הקובץ נראה בפועל:

לפני שאתם בוחנים איך הקובץ נראה, חשוב לוודא שאתם לא חוסמים את כל הבוטים או את גוגל בוט ספציפית. אם אתם מזהים את השורות הבאות, עליכם לתקן זאת בהקדם:

User-agent: *

Disallow: /

או:

User-Agent: googlebot

Disallow: /

אם לא זיהיתם את השורות האלו, השלב הבא הוא לוודא שאתם לא חוסמים בטעות כל מיני קבצים שגוגל צריך לראות. חשוב מאוד להקפיד על הדברים הבאים.

שקיפות מלאה ופירוט תכנים זדוניים

חסימה של קבצים מסוימים, או של חלקים מסוימים בקוד, עשויה לדחוף את גוגל לבצע הנחות שיזיקו לנו. לגוגל אין דרך לדעת הכל לגבי האתר שלכם, וכמו כן, אין למנוע החיפוש דרך מעשית לבחון כל היבט והיבט באופן ידני. כפועל יוצא מכך, חשוב לנקוט בזהירות ולא לייצר אותות אזהרה מלאכותיים מצדנו.

מה הבעיה, בעצם?

הימצאותם של קבצים חסומים באתר מובילה את גוגל לנקוט במשנה זהירות גבוה יותר, ו’להכתיר’ את האתר כזדוני ומסוכן, אף במקרה שלא הוכח כמניפולטיבי.

פתרון:

עברו על הרשימה הבאה כדי לוודא שאינכם שולחים לגוגל סימני אזהרה, מבלי להתכוון.

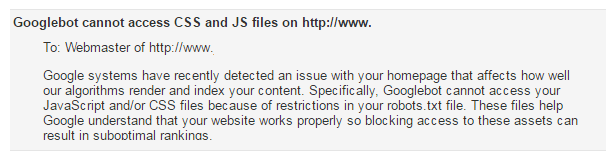

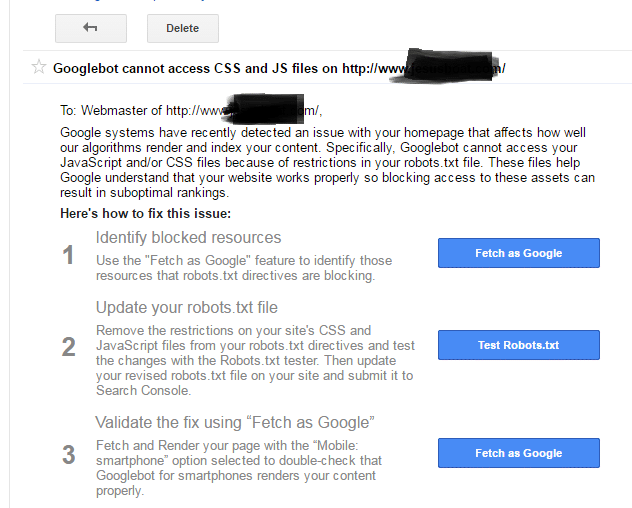

- לעולם אל תחסמו את קבצי ה-JavaScript וה-CSS בקובץ ה-txt שלכם, גוגל שמים על כך דגש רב. לא ברור אם הסיבה לכך היא שמדובר בפעולת מנע מפני האקרים שעלולים לעשות שימוש בקבצים הללו לשם ביצוע מניפולציות שונות על התוכן, או שזה בעקבות כך שהבוטים נתקלים בעמוד משובש/חסר, בו הקוד לא זמין להם. כך או כך, אם גוגל מבחינים בבעיה, לרוב הם ישלחו לכם הודעה בגין כך – אבל אתם ממש לא רוצים לקחת את הסיכון ולהמתין להודעה כזו.

במקרים אחרים, ההודעה עשויה להראות כך:

הייתי מרחיק לכת וממליץ להוסיף את השורות הספציפיות הללו לקובץ שלכם:

User-Agent: Googlebot

Allow: .js

Allow: .css

שימו לב שלא לחסום קבצי תבנית (template), אשר גם, דרך אגב, חוסמים JS ו-CSS. זו שגיאה נפוצה לחשוב שחסימה של הקבצים עללו מסייעת לגוגל לזחול בתוכן האתר במקום בקבצי קוד, אך לא כך זה עובד. אך בעלי אתרי WordPress צריכים לחסום את ספריית ה-Plugins שלהם.

- על אף שגוגל מסוגל לפענח (‘לקרוא’) טקסט, הנוכחות של תמונות בגוף התוכן חשובה לא פחות. אל תחסמו את גוגל מלזחול בספריית התמונות שלכם. חסימה של ספרייה זו תביא לכך שכל התמונות שלכם לא יאונדקסו, וכפועל יוצא מכך, תפחת כמות התוכן שמסווגת תחת האתר שלכם. אין הוכחות חותכות לכך שחסימת ספריית התמונות מזיקה לדירוגים, אך היא אמורה להוביל לירידה בתנועה הנכנסת בעקבות אובדן התנועה שמקורה בחיפוש תמונות (Google Image Search). אם אין הצדקה לחסימה של קבצי מדיה, המנעו מכך בכל מחיר.

- המנעו מחסימה של ספריית ה-RSS Feed שלכם. מדובר במקור מידע חשוב עבור גוגל (ועבורכם, אם חושבים על זה), חשוב אף יותר ממפת האתר.

שלב 2

לאחר שווידאתם שאינכם חוסמים במכוון דפים מסויימים באתר דרך ה-robots.txt, עכשיו תרצו לוודא שאינכם חוסמים דפים חשובים באתר על ידי שימוש בתג NOINDEX. על מנת לוודא זאת, עליכם לעבור על הקוד של כל דף ודף באתר ולוודא שתג זה אינו נמצא:

>meta name=”robots” content=”noindex, nofollow”<

אם מדובר באתר קטן, אז ניתן להגיע לקוד האתר באמצעות View Source או על ידי לחיצה על Ctrl+U. לאחר מכן, חפשו באמצעות פקודת Ctrl+F את המילה noindex. המצב שאמור להיות הוא שאינכם מוצאים כלום. אם מצאתם משהו, המשמעות היא שהדף הספציפי חסום למנועי חיפוש.

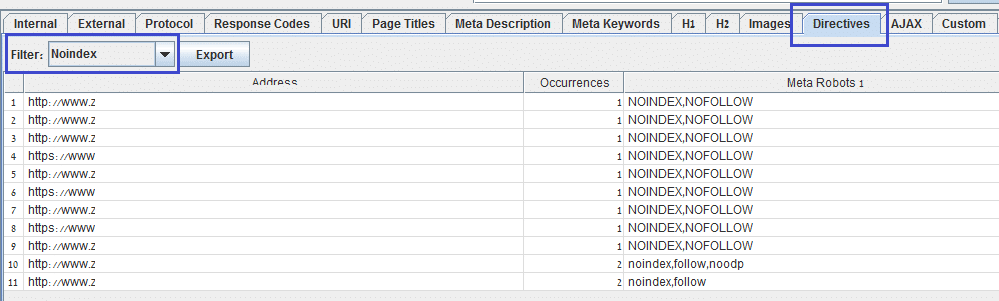

אם מדובר באתר גדול המכיל עשרות, מאות או אלפי דפים, חיפוש בקוד עלול להסתיים באשפוז מרצון! לכן, ניתן להעזר בכלי Screaming Frog כדי לסרוק את האתר (התכנה חינמית לסריקה של עד 500 דפים). בסיום הסריקה, לחצו על הטאב Directives ואז בפילטר בחרו ב-noindex:

בטבלה זו יופיעו כל הכתובות החסומות. עצם הופעת כתובות לא מצביעה ישירות על כך שיש בעיה. עברו על הכתובות מצד שמאל ווודאו שדפים חשובים אינם חסומים. אם זיהיתם משהו חשוב חסום, זה הזמן לטפל בכך.

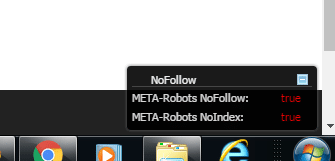

דרך שלישית לוודא שאין דפים חסומים היא באמצעות התוסף “Nofollow”. אני משתמש בו באופן קבוע לא בשלב האנליזה, אלא יותר בבחינה של דפים ספציפיים. מדובר בתוסף שעובד ברקע ותמיד יכול לעזור לכם לאתר דפים חסומים מבלי שזכרתם אפילו לבדוק. במידה והתוסף מזהה דף שהוא noindex, nofollow או אפילו רק אחד מהם, יקפוץ חלון מצד ימין למטה של המסך ויתריע על בעיה:

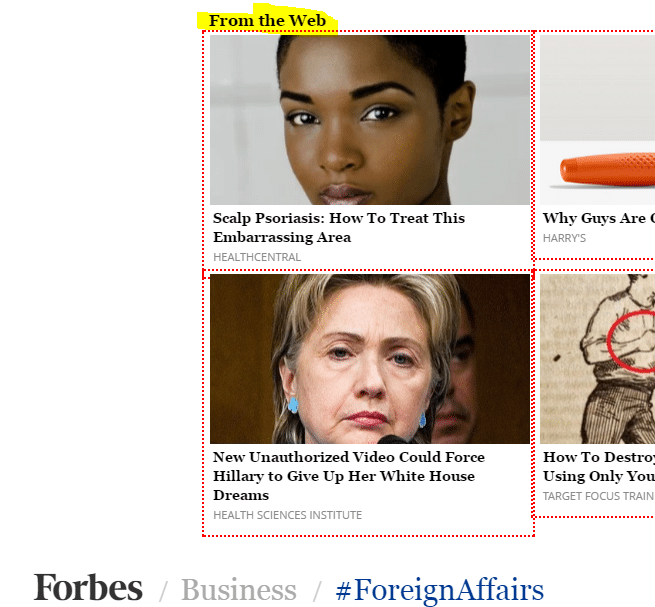

מאפיין חביב נוסף שהתוסף מציע הוא סימון לינקים המתויגים ב-nofollow בקו אדום מקווקו. פעולה זו מסייעת לזהות במהירות מה טבעם של הקישורים בדף הספציפי או באתר בכלליות. למטה ניתן לראות כיצד באתר Forbes חוסמים את כל הקישורים היוצאים אל כתבות מרחבי הרשת:

שלב 3

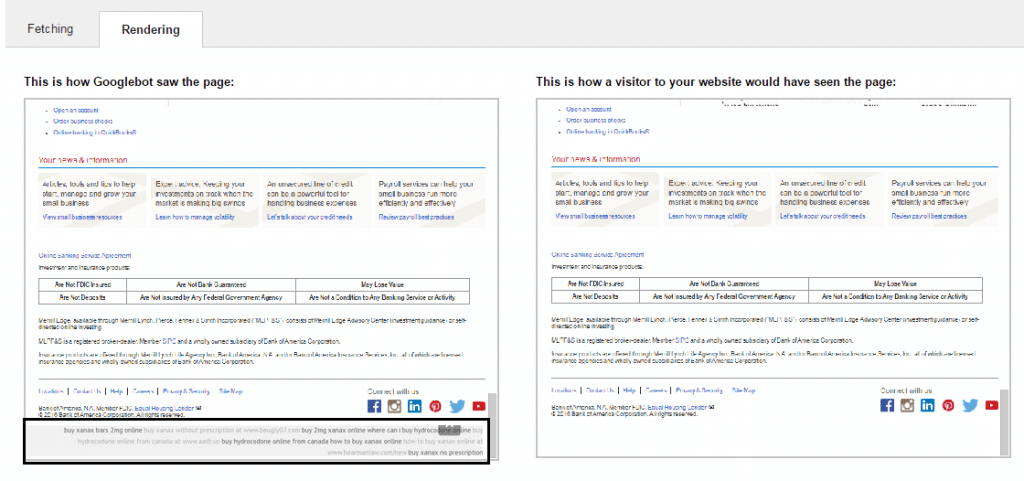

אם הגעתם לשלב זה, אתם יודעים שגוגל מצליח להגיע ולזחול באתר שלכם ללא חסימות מיותרות. כל הכבוד! עם זאת, לפני שנתעמק עוד בהיבט הטכני, יש לוודא שגוגל “רואה” את אותה גרסה של האתר שהמשתמש רואה, אחרת זה יכול להעיד על בעיה או חלילה פריצה לאתר.

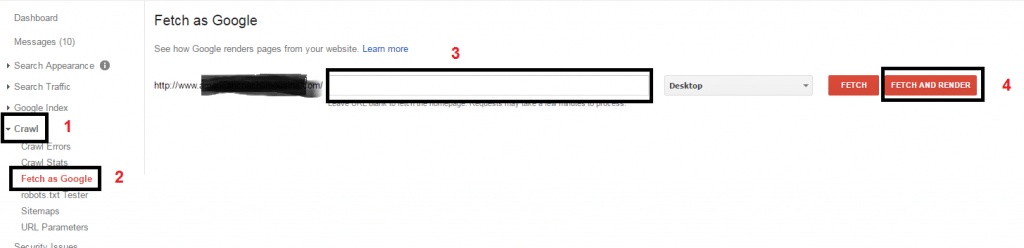

על מנת לבדוק זאת, יש לדגום את דף הבית ודפים מרכזיים נוספים באתר. כדי להתחיל בבדיקה, גשו ל-Search Console

Crawl > Fetch as Google

בעת בדיקת דף הבית, דלגו על צעד מס’ 3. בבדיקה של דפים פנימיים, ודאו שאתם מכניסים לחלון החיפוש אך ורק את ה-URI של העמוד ולא את הכתובת המלאה, אחרת תתקבל שגיאה.

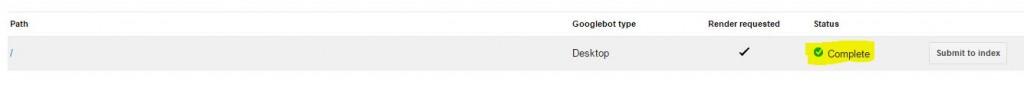

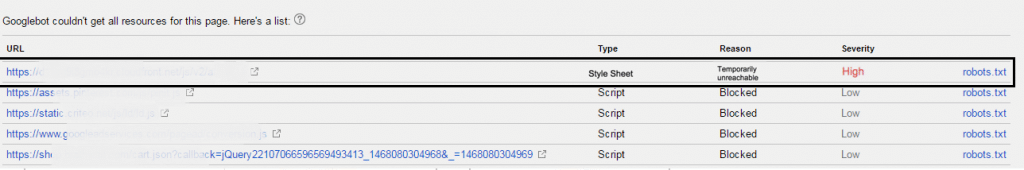

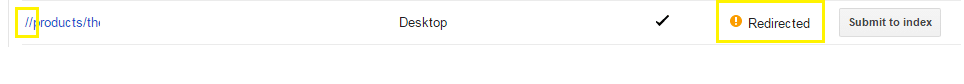

הבדיקה יכולה לקחת החל מכמה שניות ועד מספר דקות, תלוי באתר. לאחר שהבדיקה הסתיימה, הסתכלו על שורת התוצאה. ישנן כמה תוצאות אפשרויות:

Complete – זו התוצאה לה נייחל כמובן, פירושה שגוגל הצליח לזחול בכל העמוד.

Partial – פירוש תוצאה זו הנו שהעמוד נגיש (render) לגוגל בצורה חלקית בלבד. חלק מהאלמנטים לא נגישים זמנית או חסומים באמצעות robots.txt, במקרה כזה לחצו על שורת התוצאה על מנת לראות כיצד גוגל רואה את העמוד:

בדוגמה הזו ניתן לראות שגוגל מדווח על חסימה בדרגת חשיבות “גבוהה”, כיוון שמדובר בקובץ CSS שחסום, חסימה אשר מסכנת את האתר בענישת פנדה.

Redirected – פירוש תוצאה זו הוא שהעמוד מעביר את הזחלן לעמוד אחר, ולכן גוגל לא מצליח לזחול בעמוד המקורי. בדקו שאתם מכניסים את הגרסה הסופית של כתובת הדף, אחרי הרדיירקט. מצב שכיח נוסף שיכול לקרות הוא שהכנסתם את הכתובת כולל קו נטוי (ה-/) ולכן גוגל בודק כתובת המכילה שני קווים נטויים (//) במקום אחד:

Not Found – העמוד לא נמצא, ככל הנראה מחזיר שגיאת 404. בדקו שהכתובת נכונה ושאין בנמצא איזו חסימה אשר מונעת מגוגל להגיע לעמוד.

Unreachable – הבוט של גוגל המתין במשך פרק זמן שעולה על זה שנקבע מראש להמתין, או שלא הצליח להגיע לעמוד. ייתכן שמדובר בבעיית מהירות טעינה. גורם נוסף לקבלת תוצאה זו עשוי להיות חסימה של הבקשה על ידי השרת, מכל סיבה שהיא.

Blocked – גוגל לא הצליח לסרוק את העמוד כיוון שחסמתם אותו, ככל הנראה דרך ה-robots.txt שלכם.

Unreachable robots.txt – גוגל לא מצליח לגשת לקובץ ה-robots.txt שלכם. ייתכן שאתם חוסמים את הבוט של גוגל בקובץ, עליכם לבדוק זאת.

Not authorized – השרת שלכם חוסם את הבוט מגישה לכתובת העמוד, כנראה שגיאה 403.

DNS not found – אתם מחפשים דומיין לא נכון. שימו לב שכתובת האתר המופיעה ב-Search Console היא הגרסה הנכונה, עם www או ללא, http או https, (זה יכול להשפיע על התוצאה).

Temporarily unreachable – גוגל לא יכול להגיע זמנית אל העמוד מכיוון שלשרת לוקח יותר מדי זמן להגיב או מכיוון שהגשתם מספר רב מדי של בקשות במקביל.

משביצעתם את הבדיקה, אלמלא קיבלתם Complete, עליכם ללחוץ על שורת התוצאה, לבחון מה הבעיה בהתאם למדריך לעיל, ולתקן בהתאם. עליכם לשאוף לתאימות מקסימלית בין מה שאתם רואים (צד ימין) לבין מה שהבוט של גוגל רואה (צד שמאל). דרך נוספת לבדוק זאת היא פשוט לגשת לתוצאות החיפוש ולטעון את גרסת הקאש של העמוד. שם, יש ללחוץ על גרסת הטקסט בלבד, ואז תוכלו להשוות את מה שאתם רואים כמשתמשים, ומה שגוגל בוט רואה כשהוא סורק את העמוד. תוכלו לגלות לפתע שיש חלקים שלמים של טקסט שאתם רואים בראש העמוד כמשתמשים, אך גוגל רואה רק בסוף העמוד, (הם עשויים להופיע למשתמש בראש העמוד רק בעקבות משחק עם CSS). אלו דברים שתרצו לבחון בכדי לשפר את האופן בו גוגל תופס ומדרג את האתר שלכם.

בעיות אבטחה

בחודשים האחרונים אנו עדים לריבוי מקרים של פריצות לאתרים על ידי ספאמרים. חלקם מתוחכמים יותר וחלקם פחות, אבל מוטב לדעת שאתרי וורדפרס, באופן כללי, פרוצים וחשופים יותר מאתרים אחרים, הודות לשימוש בפלאגינים שכתובים בקוד פתוח, ולפיכך עשויים להכיל פרצות אבטחה. חשוב לוודא שהאתר שלכם לא נפרץ ושאינו משמש מצע להאקרים ולספאמרים, המשתמשים באתר שלכם לטובתם האישית וגורמים לכם נזק. אבטחת אתרים הנה תחום שלם וחשוב בפני עצמו, אך זה לא הנושא שעומד בלב הפוסט הזה, ולכן אגע רק בנקודות כלליות. להלן דוגמה לפריצה של האקר לאתר; פריצה זו שקופה (לא נראית) למשתמש, ולעיתים אף לא ניתנת לזיהוי גם בבחינת קוד ה-HTML, אלא זמינה רק לגוגל בוט (Cloaking):

כדי לבדוק עד כמה חמורה הבעיה, בדקו קודם אם ניתן לאתר את הקודים הללו בקוד המקור של העמוד. ייתכן שלא תוכלו לראות את הקודים אלא אם תגדירו “צפיה כגוגל בוט” בהגדרות.

זו דוגמה להשתלת קודים הקשורים לאתרי תרופות ופורנו, בעיה חמורה אשר לרוב מצריכה טיפול מקיף ביותר מכיוון שלרוב, ההאקר משתיל קודים בלב של האתר ולא רק בפרונט אנד. לכן לרוב, בעיקר אם מדובר באתרי וורדפרס, ההמלצה המרכזית היא להסיר את ההתקנה של וורדפרס לחלוטין ולהתקין מחדש, ורק אז לחבר שוב את האתר ללא הפלאגינים. לבסוף, יש להפעיל אך ורק את הפלאגינים שצריך.

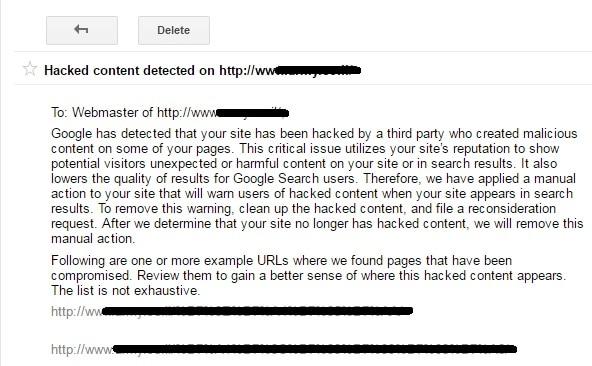

אם גוגל עוד לא זיהה את הבעיה באתר, יש לכם הזדמנות לטפל בנושא בהקדם, לפני שייגרם נזק לדירוגים. אם גוגל כבר זיהה את הבעיה, ייתכן מאוד שתקבלו הודעה כזו:

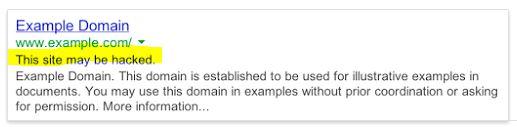

במקרה כזה גוגל יוסיף הודעה בתוצאות החיפוש המזהירה גולשים מכניסה לאתר שלכם:

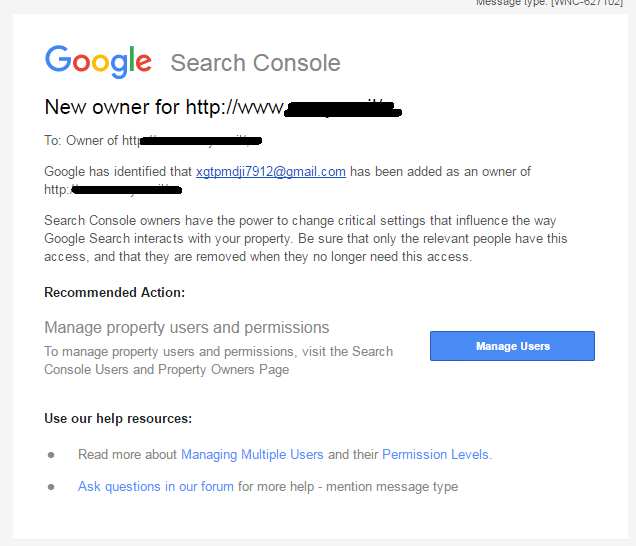

במקרים מסויימים, ההאקר הופך עצמו לבעלים של האתר ומעניק לעצמו שליטה מלאה על ה-Search Console. לעיתים, ההאקר אף מסיר אתכם מניהול על ידי הסרה של קוד האנליטיקס מהאתר או כל קוד ששמתם על מנת לזהות עצמכם בפני גוגל.

אם אתם קמים בבוקר ומקבלים הודעה כזו מגוגל:

דעו שמישהו השתלט לכם על האתר ואתם חייבים לטפל בנזק בהקדם, לפני שייגרם אפילו יותר נזק.

שלב 4

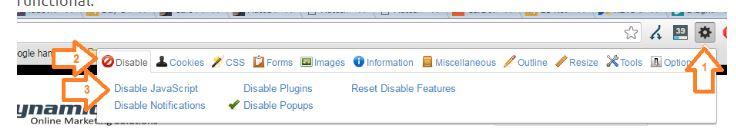

האם התפריטים שלכם נסרקים ונגישים לגוגל? מדובר בשאלה לגיטימית אשר התשובה עליה לא תמיד ברורה לכולם. בעבר הלא רחוק, נהוג היה להרכיב תפריטים עם תפריט נפתח, באמצעות JS. המודעות לכך היה נמוכה ולכן התפריטים לרוב לא היו ברי סריקה ולכן לא נחשבו, מבחינת גוגל, לקישורים פנימיים. כיום, הבעיה פחתה ורוב התפריטים בנויים ב-html, או שישנה גרסת html לתפריט. על מנת לוודא זאת נשתמש בתוסף כרום בשם Web Developer Toolbar.

על מנת לבדוק זאת, נבחר באופציה להצגת האתר ללא JS, ונרפרש את העמוד:

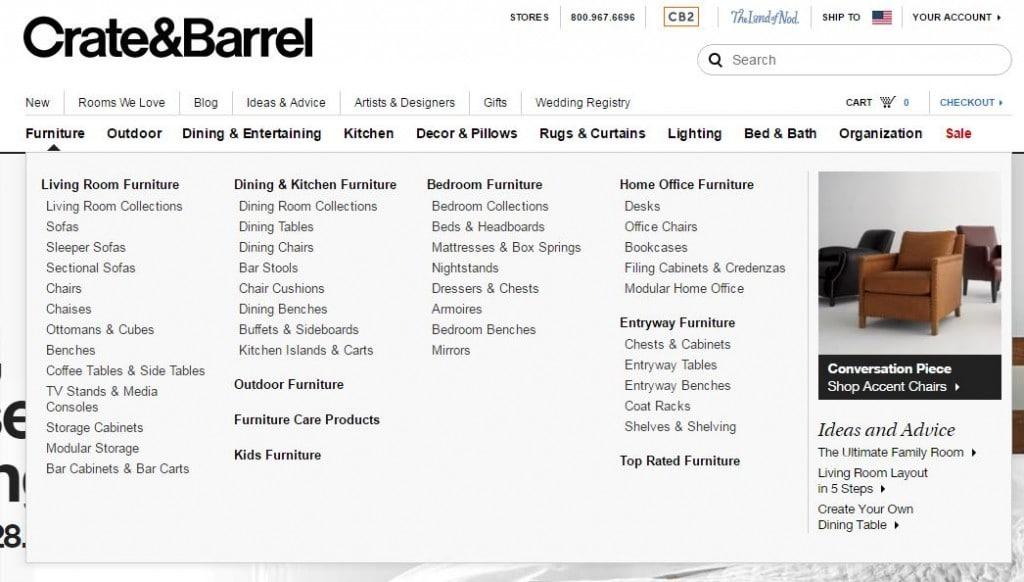

שימו לב לתפריט הנפתח עם כל תתי הקטגוריות, כך הוא מוצג למשתמש תוך שימוש ב JS:

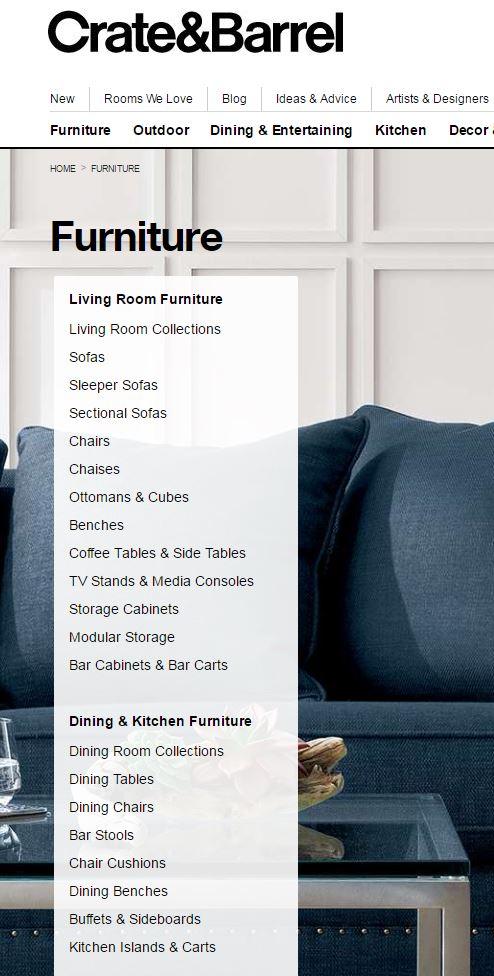

לאחר השימוש בפלאגין וביטול השימוש ב JS, העמוד ייראה כך. ניתן לראות שהתפריט נראה מעט שונה, אך עדיין נגיש וויזואלי.

שלב 5

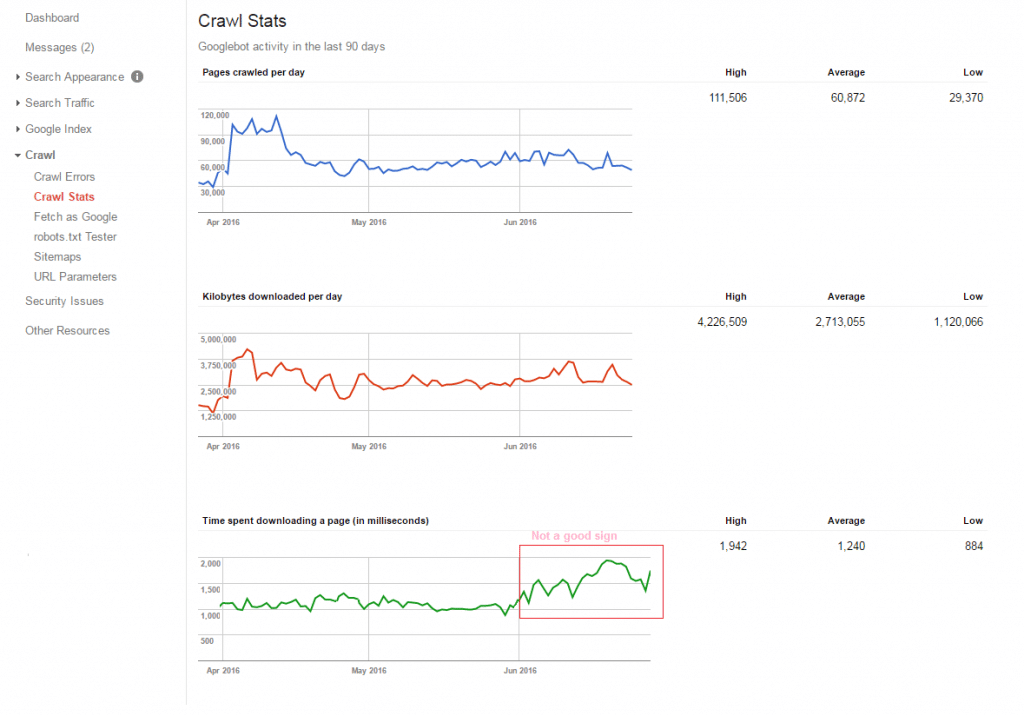

כעת, משווידאנו שאיננו חוסמים את האתר במכוון או בטעות דרך קובץ ה-robots.txt או דרך תגים בעמוד עצמו, שהאתר לא נסרק בצורה מוזרה או שהוא – חלילה – פרוץ, הגיע הזמן לבדוק האם ישנן חריגות בקצב הסריקה של האתר. בשלב זה, נבדוק את כמות הדפים הנסרקים וזמן הורדת העמודים. עליה בזמן הורדת העמודים משמעה פחות דפים שייסרקו בפוטנציה. על מנת לבדוק זאת, גשו ל-Search Console: Crawl > Crawl stats.

אם אתם מזהים משהו חריג, בדקו מה שיניתם בזמן האחרון, מהירות שרת, הפניות, דפים חדשים שהועלו לאתר, לינקים שבורים או כל דבר אחר אשר עשוי להאט את האתר.

שלב 6

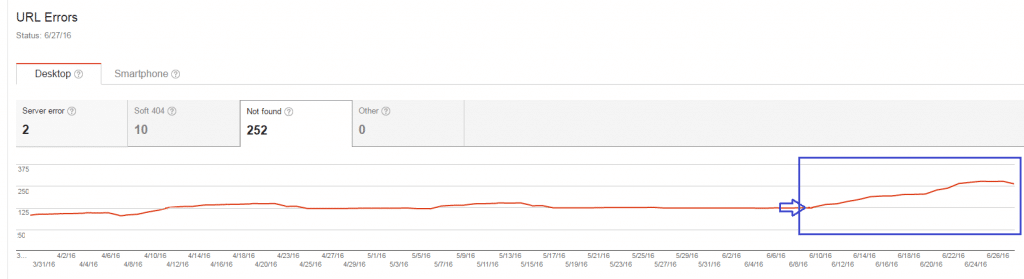

בשלב זה, יש לוודא שאין עליה בכמות השגיאות באתר. קפיצה בכמות השגיאות באתר עשויה להצביע על בעיות סריקה נקודתיות כגון נפילת השרת, עומס רגעי ועוד (כל עוד זה קורה אחת לכמה חודשים, אין עם כך בעיה). לחילופין, עליה קבועה בכמות השגיאות מצריכה טיפול ותשומת לב. גשו ל-

Search Console: Crawl > Crawl Errors.

עליה הדרגתית בשגיאות, כפי שנראה בצילום המסך להלן, יכולה להעיד על בעיה בהתהוות, אשר גורמת לעוד ועוד דפים להחזיר שגיאת 404. יש לחקור את הגורם לבעיה, ולטפל בה.

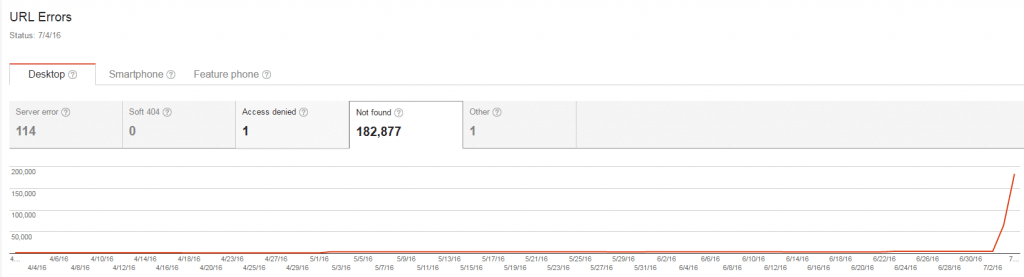

לעומת זאת, אם קרה משהו חריג באתר המשפיע בצורה דרסטית על הסריקה, אתם תראו קפיצה בבת אחת במספר השגיאות, הנראית ככה:

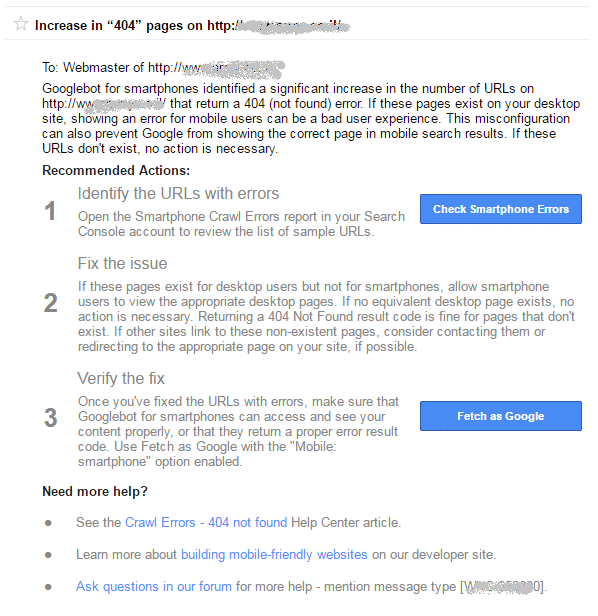

קפיצה כזו לרוב תלווה בהודעת אזהרה מגוגל אשר תתקבל אל ה-Search Console של האתר. להלן דוגמאות להודעות שגוגל שולחים:

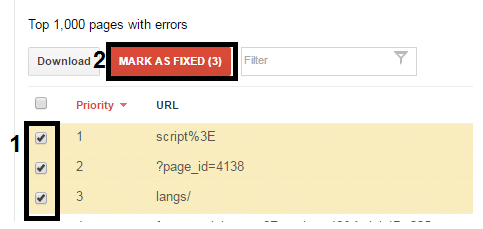

אם קיבלתם הודעה כזו, כנראה שגם תראו עליה בשגיאות שרת (500). בדקו בהקדם אם האתר באוויר ואם השרת מתפקד כראוי. אם הכל נראה תקין בגזרות אלו, בצעו בדיקה עם screaming frog – אם הוא מצליח לגשת לאתר זה אומר שהבעיה אינה חמורה. אם הוא לא מצליח לגשת לאתר, יש לבדוק לעומק מה הסיבה ואף לשקול ליצור קשר עם חברת האחסון לבדיקה מעמיקה יותר. אם כמות השגיאות אינה עולה על 1000, תוכלו לסמן ב-Search Console את כל הדפים וללחוץ על Mark as Fixed.

המתינו יום או יומיים ובדקו האם דפים חדשים מתווספים לרשימת השגיאות. אם מדובר בבעיה נקודתית, הדפים אמורים להעלם, ובמקביל דיווחתם לגוגל שהבעיה טופלה.

הערה: בדקו אם ישנה עליה בכמות שגיאות השרת, ואל תשכחו להחליף טאב ולבדוק את אותו הדבר גם בנוגע לשגיאות במובייל. אלו יכולות להיות שגיאות שונות לחלוטין.

אי אפשר לדבר על שגיאות 404 מבלי לוודא כמובן שהדף מוגדר כראוי. דף 404 למעשה הוא כינוי לסטטוס קוד שהשרת מחזיר בעבור דף שלא נמצא. כל הבדיקות שערכנו עד כה, ההגדרות בכלים השונים וכו’, מתבססות על ההנחה שהדף עצמו מוגדר נכון במערכת ואכן מחזיר סטטוס קוד 404 ולא 200. נתקלתי כבר בהרבה אתרים בעלי דף 404 מעוצב וידידותי אך לא מוגדר נכון, המחזיר סטטוס 200 במקום 404.

על מנת לבדוק זאת, גשו אל

Search Console: Crawl > Crawl Errors > URL Errors > Soft 404s

שגיאה soft 404 משמעה דף שמציג “דף לא קיים” אך אינו מחזיר סטטוס קוד 404 בשרת. בטוח נתקלתם בצורה הכי נפוצה של שגיאה זו, שקורית כאשר אתם לוחצים על לינק מסויים ופשוט נוחתים בדף הבית. ההגדרה הכי נפוצה לטיפול בשגיאה זו היא הפניה אוטומטית אשר יכולה להופיע בדמות הפניית 302 או 301 אל דף הבית. במקרים שונים, אין הפניה מוגדרת, ואתם תגיעו אל דף 404 ידידותי אשר מחזיר סטטוס קוד 200.

שלב 7

יש לכם אתר איקומרס? הבדיקה הזו נועדה במיוחד בשבילכם! לרוב אתרי האיקומרס יש בעיה של ריבוי דפים שמתאנדקסים מסיבות רבות, החל מבעיות שקשורות לפלטפורמה עליה יושב האתר ועד שכפול דפים מראש, ללא כוונה, כתוצאה משימוש בפילטרים או מסיבות של מרצ’נדייזינג ורצון להראות מוצרים מסויימים במגוון קטגוריות. אם יש לכם רק כמה עשרות מוצרים באתר, יש סיכוי סביר שהמצב עדיין בשליטה מלאה. עם זאת, אם מדובר באתר המוכר מאות ואף אלפי פריטים, המצב יכול לצאת משליטה די מהר – ותמצאו את עצמכם עם מאות אלפי דפים מאונדקסים בגוגל. ראשית, מצב זה מפריע לגוגל להבין את האתר כפי שאתם רוצים, ושנית, גוגל מבזבז זמן יקר על דפים לא חשובים/לא אקטואליים, בנוסף לעובדה שהכוח של האתר שלכם כעת מתפזר ולא מתמקד סביב הדפים שחשובים לכם באמת. על מנת לבדוק זאת, עליכם לבצע רצף של בדיקות, זה יקח זמן אבל זה ישתלם.

על מנת להתחיל את הבדיקות, תצטרכו גישה ל-Bing WMT, Search Console ואנליטיקס.

התחילו בבדיקה הבסיסית שנועדה לראות האם יש בעיה בכלל. גשו ל-

Search Console: Google Index > Index Status.

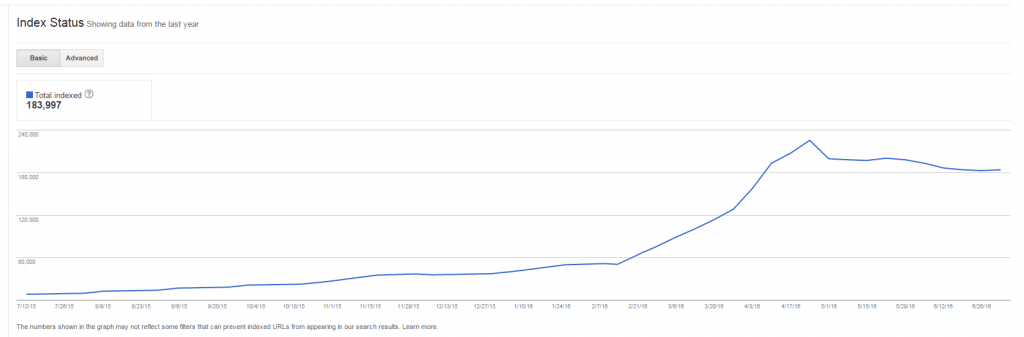

הנה דוגמה לאתר המכיל סה”כ כ-4800 עמודים בפועל, והגיע למצב בו מאונדקסים כמעט 200,000(!) עמודים:

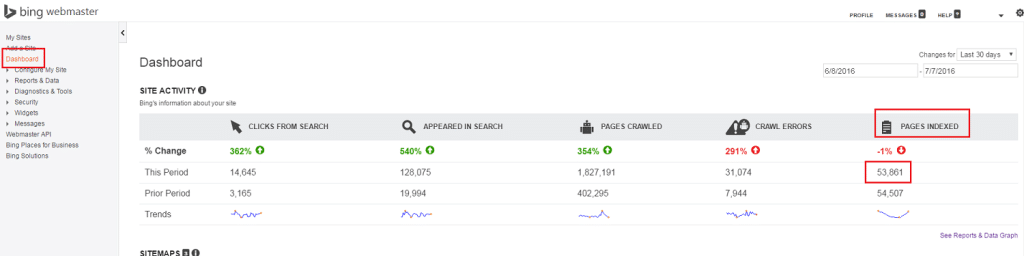

כעת ברור לכם שישנה בעיה עם כמות הדפים המאונדקסים בגוגל. יש לעבור ולבצע את אותה בדיקה בבינג (הערת אגב, למי מכם שעובדים בארה”ב, בינג מתחזקים בחודשים האחרונים ומכניסים תנועה ורווחים יפים. זאת ועוד, גם יחס ההמרה של תנועה אורגנית שמקורה בבינג גבוה משמעותית מיחס ההמרה מתנועה אורגנית שמקורה בגוגל). על מנת לבדוק זאת, גשו ל Bing Webmaster Tools.

Dashboard > Site Activity >Pages Indexed

כפי שניתן לראות, בבינג המצב יותר טוב אבל גם כאן מדובר בכמות של פי עשרה יותר דפים מאונדקסים מאשר קיים בפועל. כדי להבין אילו דפים חשובים לנו באמת מתוך כל אלו, נעבור לבדיקה הבאה, לשמה ניגש לאנליטיקס.

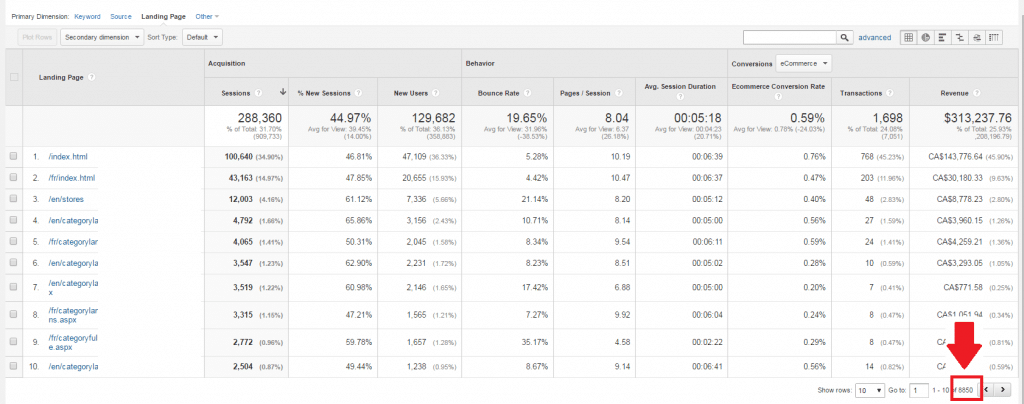

לפני הכל, חשוב לציין את עניין הסמפלינג (הצגת מדגם). גוגל אנליטיקס מספקים מידע מדוייק עד 250,000 sessions. באתרים גדולים, אנו נתקלים בבעיה בה המידע שנראה בדוחות מורכב אך ורק מאחוזים בודדים מהתנועה, ולכן, במקרים מסויימים, המידע כמעט חסר משמעות. מסיבה זו, יש לשים לב לעניין גודל המדגם אם אתם מנתחים אתרים בעלי תנועה גדולה. מי שרוצה ללמוד עוד על הנושא, מוזמן לקרוא כאן.

על מנת להימנע מהטיית סמפלינג במקרה שלנו, ניתן להשתמש בטריק קטן שיאפשר לצפות במידע המלא (אם מישהו יודע למה דווקא כאן אין סמפלינג, אשמח לדעת). במקום לגשת למידע האורגני דרך:

Acquisition > Campaigns > Organic Keywords > Change Primary Dimension to Landing Page

יש לגשת דווקא כך:

Acquisition > All Traffic > Channels > Organic Search > Change Primary Dimension to Landing Page

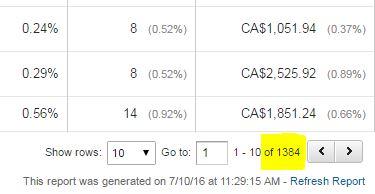

הסתכלו בפינה הימנית למטה, כמה סה”כ דפי נחיתה מכניסים תנועה לאתר. במקרה שלנו מדובר ב-8850 דפים. אם תסתכלו למעלה, תראו שגוגל מאנדקס מעל 180,000 דפים, מה שאומר שפחות מ-5% מהדפים מכניסים תנועה לאתר.

כעת, יש להמשיך לבדיקה הבאה, שמטרתה לחשוף כמה מן הדפים הללו מכניסים תנועה משמעותית ולא רק מספר כניסות מצומצם. על מנת לבצע את הבדיקה, סננו את הדוח כך שיראה רק דפים אשר הכניסו מעל 10 Sessions (או כל מספר אחר שאתם מחשיבים למינימלי) וכך זה אמור להראות:

עכשיו התמונה הרבה יותר ברורה. במקרה של הדוגמא, ישנם למעשה רק 1384 דפים אשר מכניסים תנועה נורמלית לאתר. מדובר במספר הגיוני הרבה יותר מאשר 180,000 הדפים שמאונדקסים בגוגל. מה עכשיו?

אתם יכולים להוציא דוח של אותם דפים, אשר מכניסים תנועה פחותה ממה שהגדרתם, ולנסות להבין אם יש מכנה משותף ביניהם. במידת הצורך, תוכלו להתחיל לחסום.

להלן שלוש סיבות מרכזיות שיכולות לגרום לניפוח כמות הדפים (אם כי יכולות להיות עשרות סיבות שונות):

- אי חסימת פרמטרים שונים – פרמטרים של פילטרים כגון צבעים, מידות, חומרים וכו’. אתם יכולים לחסום זאת דרך Search Console או להשתמש בקנוניקל מכל דפי הפילטרים, אשר יפנה אל דף הקטגוריה עצמו.

- אי חסימת דפי הזמנה – דפי הצ’קאאוט, דפי סיום הזמנה או דפי חיפוש באתר אינם חסומים, ולכן כל תוצאה כזו מתאנדקסת ומגדילה את נפח האתר עם כל יום שעובר.

- אי חסימת דפי קטגוריה של הבלוג, תגים וארכיון – אם אתם מנהלים בלוג פעיל במיוחד דרך אתר וורדפרס, מומלץ מאוד לבדוק את הסעיף הזה.

בכל מקרה, לפני שאתם מחליטים לחסום, להפנות או ליישם כל פתרון יצירתי אחר, בדקו באנליטיקס כמה תנועה דפים אלו מקבלים על מנת שלא תגרמו נזק. אם יש תנועה לדפים מסויימים ואתם מעוניינים שאותה תנועה תגיע לדף אחר שהכנתם במקום, השתמשו בהפניות 301.

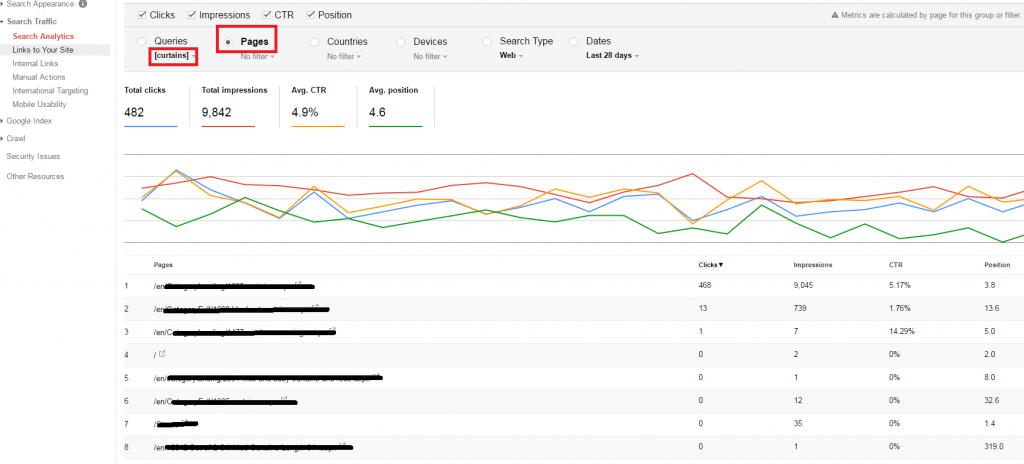

דרך נוספת לנסות לאתר חוסר מיקוד בגוגל היא להבין אילו דפים גוגל מזהה כחשובים עבור ביטויי חיפוש מרכזיים. בדיקה זו מומלצת באופן כללי, על מנת להבין אם מאמצי הקידום שלכם אכן ממקדים את גוגל או שמא נדרשת עבודה נוספת. כדי לבדוק את העניין, גשו ל-

Search Console: Search Traffic > Search Analytics.

סמנו בתפריט העליון את כל התיבות, ובחרו את הביטוי המבוקש תחת Queries (ניתן לחפש אותו דרך חלון החיפוש).

כעת, לחצו על Pages. אם אתם מקבלים את עמוד הנחיתה הרצוי, מעולה! עברו לביטוי הבא. אם לא, בדקו מה גורם לחוסר המיקוד. יכול להיות שמדובר בדפים מיותרים, עניין של שינוי טייטלים או קישורים פנימיים.

הנה דוגמה למצב לא רצוי, ניתן לראות כי ישנם מס’ דפים המופיעים בתוצאות החיפוש בגוגל אשר מושכים ומסיטים תנועה מהדף הרצוי. כיוון שגוגל יכול להציג דפים אלו לפי ראות עיניו, ישנם מצבים בהם הגולשים מקבלים דפים חלופיים, ללא אופטימיזציה, טייטלים ותיאור עמוד שהשקענו בהם מחשבה ועבודה רבה, ולכן אנו מפסידים קליקים פוטנציאלים:

שלב 8

אם יש לכם בלוג, כנראה חסמתם את עמודי התגים והארכיון, אך האם דאגתם לעימוד (pagination) נכון? זו בעיה נפוצה שיכולה לגרור שלל בעיות, החל מחוסר מיקוד ובזבוז משאבי סריקה על דפים לא חשובים, ועד ריכוז תנועה משמעותי אשר יגיע לדפים אלו במקום דפים מרכזיים באתר אשר הסיכוי שיובילו למכירה, גדול יותר.

באופן כללי, גוגל מעדיף לדרג את הדף הראשי של הבלוג ולא את כל שאר העמודים. מאידך, חשוב ליידע את גוגל בדבר היררכיה וקשר (סדרתיות) בין דפים אלו. ישנן המון הגדרות מתקדמות שניתן להגדיר, כמו הוספת תגי noindex על כל העמודים החל מעמוד שני והלאה, שינוי הגדרות הסריקה ב-Search Console ועוד, אבל אני מעדיף לא לגעת בדברים אלו היות שהם יכולים לגרום לכם יותר נזק מאשר תועלת. כן מומלץ להוסיף nofollow על כל העמודים החל מעמוד שני, כדי למנוע בזבוז כח על עמודים אלו מחד, ומצד שני למנוע מגוגל לבזבז זמן סריקה יקר עליהם.

כדי לבדוק אם יש לכם בעיה כזו, אתם יכולים לגשת קודם לקוד המקור של עמוד הבלוג ולבחון אם יש לכם אלמנט rel=”next” על העמוד. אם מצאתם אלמנט זה, גשו לעמוד השני וחפשו אם אתם מוצאים אלמנט rel=”prev” אם מצאתם גם את זה, ככל הנראה יש לכם עימוד מוטמע בעמודים. בשלב זה, יש לבדוק האם יש לכך השפעה שלילית על האתר. לטובת העניין, גשו לאנליטיקס והביטו בדו”ח דפי הנחיתה האורגניים:

Acquisition > All traffic > Channels

שנו את הממד (Dimension) הראשי ל-landing pages.

כעת חפשו את המילה Page בחלון החיפוש. אם אתם רואים שיש תנועה לעמודים אלו, ייתכן מאוד שאתם חווים קניבליזציה של תנועה אשר אמורה להגיע אל העמוד הראשי של הבלוג במקום לעמודים אלו.

דבר נוסף שיש לבדוק הוא אם התגים הוטמעו כמו שצריך. על מנת לבדוק זאת, גשו ל-Search Console ולכו אל דו”ח השגיאות, חפשו בחלון את המילה Page; אם אתם רואים עמודים עם מספרים גבוהים מאוד, הרבה מעבר למה שיש לכם באתר באמת ייתכן מאוד כי לא הטמעתם את הקוד כמו שצריך בדף האחרון. בדקו אם בדף האחרון שמתם בטעות גם את האלמנט rel=”next” אשר גורם לגוגל להמשיך לאנדקס עוד דפים בסדרה שלמעשה לא קיימים.

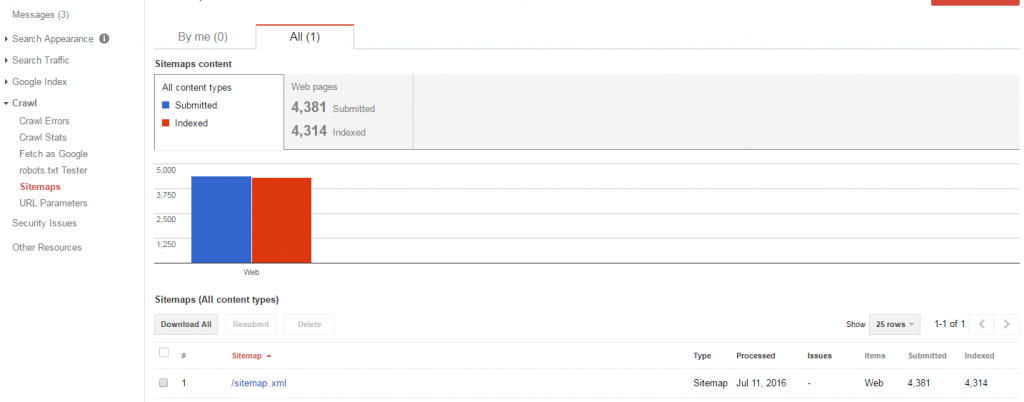

שלב 9

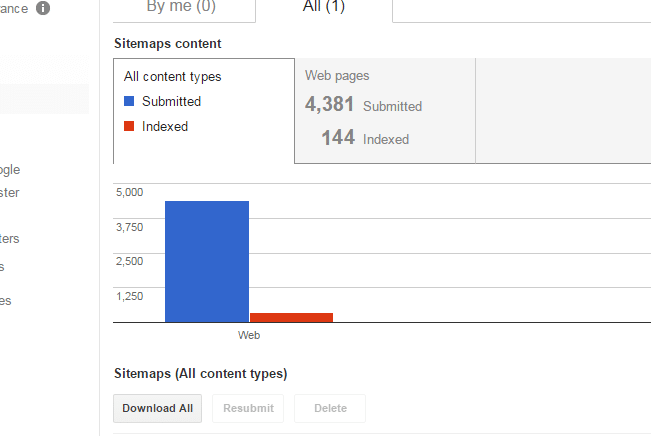

לא ניתן לדבר על סריקה ואופטימיזציה מבלי לדבר על מפת אתר. מפת אתר הינה אחת הדרכים שלנו להציג לגוגל את הדפים החשובים לנו. הפורמט המקובל הוא XML. את מפת האתר תעלו כמובן אל תיקיית השורש של האתר. כאשר המפה מעודכנת ומותקנת כמו שצריך אתם תוכלו לראות נתונים אודות כמות הדפים שהגשתם לגוגל, לעומת כמות הדפים שנסרקו בפועל והשגיאות השונות (אם יש). כך נראית מפת אתר תקינה, כמות הדפים שהגשתם תהיה כמעט זהה לכמות הדפים שגוגל אינדקס.

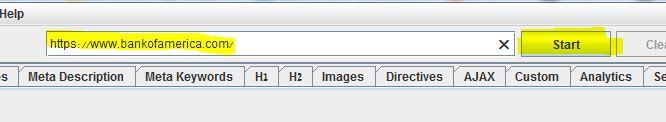

ישנם מספר כלים שדרכם אפשר לייצר מפת אתר. הנפוץ והוותיק מכולם הוא הכלי הזה, דרכו תוכלו לייצר מפות אתר שונות בחינם, עבור אתרים שגודלים עד 500 דפים. מעל למספר זה, כנראה שתצטרכו את הגרסה בתשלום. מעבר לכלי זה, ניתן לייצר מפת אתר בקלות גם דרך Screaming Frog. בדומה לכלי הראשון, אם יש לכם אתר עד 500 עמודים תוכלו להשתמש בכלי בחינם, אך אם מדובר באתר גדול יותר, תצטרכו לרכוש רשיון.

גשו אל התוכנה והכניסו את כתובת האתר בחלון החיפוש ולחצו על Start.

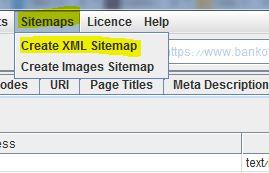

עם סיום הבדיקה, לחצו על Sitemaps ואז בחרו בתפריט שנפתח באופציה Create XML Sitemap:

בחלון שנפתח אני בדרך כלל לא נוגע, משום שהתוכנה עושה עבודה טובה בהיבט הזה של ההגדרות. אין לכם מה לחשוש מדפים שמחזירים שגיאות או הפניות, התוכנה לא תכניס אותם למפת האתר. לחצו על Next ושמרו את הקובץ, ויש לכם מפת אתר מוכנה.

אם יש לכם אתר איקומרס, ייתכן שתצטרכו מפה מעט שונה. באתרי מסחר גדולים נהוג לחלק את מפת האתר למספר מפות, לפי קטגוריות, ואז לייצר קובץ אחד כללי שנקרא אינדקס, שמטרתו לקרוא לשאר הקבצים. שיטה זו תעזור לכם להגיש לגוגל מפות אתר שונות וכך לעלות ביתר קלות על בעיות שיצוצו במפת האתר. במקום לחפש מה הבעיה בקובץ של 20,000 כתובות, גוגל ידווח לכם באיזו מבין המפות ישנן שגיאות, תוכלו לצמצם את החיפוש שלכם ולחסוך בזמן.

סוגי המפות הנפוצים ביותר הם:

- מפת תמונות – הנגשת התמונות לגוגל תאפשר לגוגל להציג את התמונות למי שיחפש ב-Images. כמו כן, אם אתם משתמשים בקמפיין של גוגל שופינג, זה לחלוטין יעזור. זהו הפורמט המקובל:

<?xml version=”1.0″ encoding=”utf-8″?>

<urlset xmlns=”http://www.sitemaps.org/schemas/sitemap/0.9″

xmlns:image=”http://www.google.com/schemas/sitemap-image/1.1″>

<url>

<loc>https://www.example.com/</loc>

<image:image>

<image:loc>https://www.example.com/images/home/DiningRoom/DiningChairs/en.jpg</image:loc>

</image:image>

<image:image>

<image:loc>https://www.example.com/images/home/061516/lg/3-en.jpg</image:loc>

</image:image>

<image:image>

<image:loc>https://www.example.com/images/home/061516/lg/4-en.jpg</image:loc>

</image:image>

</url>

<urlset>

שימו לב כי מצויין העמוד ומתחת כל התמונות השייכות לאותו עמוד.

- מפת וידיאו – עוזרת לגוגל לדרג את סרטוני הוידיאו שלכם. למי שזה רלוונטי, הנה הפורמט.

- מפת קטגוריות – כאן יוצגו בדרך כלל הקטגוריות ותתי הקטגוריות מהתפריטים. באתרי מסחר גדולים זה יכול להגיע למאות כתובות.

- מפת מוצרים – כאן יוצגו אך ורק המוצרים באתר. זו כמובן תהיה הרשימה הכי ארוכה מבין כולן, ויכולה להגיע גם לאלפי כתובות.

- מפת דפים סטטיים – נועדה לרכז את כל הדפים הסטטיים שיש באתר. דפים אלו יכולים לכלול דפים כמו צור קשר, פרטיות, אודותינו, ועוד.

עבור שלוש המפות האחרונות נשתמש בפורמט הרגיל של מפת אתר, לדוגמה:

xml version=”1.0″ encoding=”utf-8″?><!–Generated by Screaming Frog SEO Spider 5.1–>

<urlset xmlns=”http://www.sitemaps.org/schemas/sitemap/0.9″ xmlns:xsi=”http://www.w3.org/2001/XMLSchema-instance” xsi:schemaLocation=”http://www.sitemaps.org/schemas/sitemap/0.9 http://www.sitemaps.org/schemas/sitemap/0.9/sitemap.xsd”>

<url>

<loc>https://www.bankofamerica.com/</loc>

<lastmod>2016-07-14</lastmod>

<changefreq>daily</changefreq>

<priority>1.0</priority>

</url>

<url>

<loc>https://www.bankofamerica.com/onlinebanking/online-banking-security-faqs.go</loc>

<lastmod>2016-07-14</lastmod>

<changefreq>daily</changefreq>

<priority>0.9</priority>

</url>

<url>

לאחר שסיימתם לטייב את כל מפות האתר, זה הזמן לייצר את מפת האינדקס. מפה זו פשוטה מאוד ובסך הכל מראה לגוגל את הכתובות של שאר המפות. תוכלו למצוא הסבר די פשוט כאן.

חשוב מאוד להקפיד על הדברים הבאים:

- שימו אך ורק כתובות אשר תג הקנוניקל שלהן מפנה לעצמן. תוכלו למצוא דפים סוררים בקלות באמצעות

Screaming Frog: Directives > Filter: Canonicalized

שם תמצאו את כל הכתובות אשר תגי הקנוניקל שלהם מפנים אל דפים אחרים.

- אין להכניס דפים בעלי תג noindex.

- אין לכלול דפים עם הפניות, אלא אך ורק דפים סופיים.

- הקפידו לא להכניס דפי נחיתה שונים אשר משמשים לקמפיינים ממומנים.

אם יש בעיה בפורמט או בדרך בה בניתם את מפת האתר, אתם תראו שגיאות ב Search Console.

אם הסינטקס נכון ואין שגיאות, אבל אתם עדיין רואים שלאחר כמה ימים גוגל מאנדקס רק חלק קטן מהדפים שהגשתם, ייתכן שישנן בעיות נוספuת בכתובות (כתובות נכונות אך לא סופיות, מכילות דפים ישנים או דפים לא רצויים, ועוד).

כך זה עשוי להיראות – שימו לב שהכמות מצד ימין נמוכה משמעותית מכמות הדפים שהוגשו.

בתשעת השלבים לעיל ניסיתי לספק סקירה מקיפה של הבדיקות החשובות ביותר שעליכם להעביר את האתר שלכם, בדרך לזחילות מיטבית. ישנן, כמובן, בדיקות נוספות שניתן לבצע. הנקודה המרכזית היא לא לחפש לקצר את התהליך, ולהקפיד שהאתר נסרק כמו שצריך. אם לא, ההשפעה השלילית על מאמצי השיווק של האתר עלולה להיות משמעותית עד כדי הרסנית.

אם עברתם על כל המדריך, האתר שלכם בדרכו להיות בריא וקריא. אני מקווה שמדריך זה סייע לכם להבין הן כיצד לגשת אל הבדיקות השונות, הן את הדרכים לוודא (עד כמה שניתן) שהאתר מהיר, זחיל וממוקד, ולבסוף כמובן את ההיגיון מאחורי הדברים. באם חידשתי לכם בדיקות שלא ביצעתם עד כה, שתפו אותנו בתגובות לגבי הממצאים החדשים שעלו. מכירים בדיקות חשובות נוספות שלדעתכם ראוי לציין? אנו נשמח ללמוד!

גשו לעבודה, ובהצלחה!